Fresh Global Thoughts for Fearless Global Thinkers.

Welcome to Where Possibilities Begin, G-P’s blog that shares the latest ideas and insights from growth-minded innovators, business leaders, and industry executives from around the world.

What’s new in international law and compliance in 2026

G-P vs. RemoFirst: EOR comparison guide

The Power of an Integrated HR Ecosystem

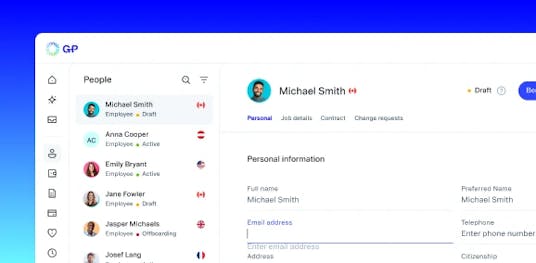

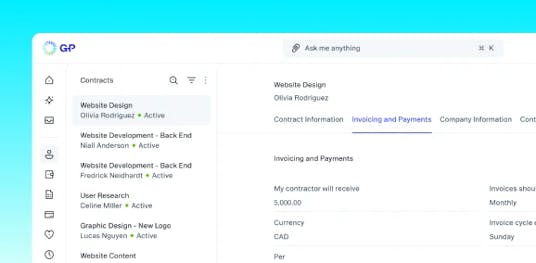

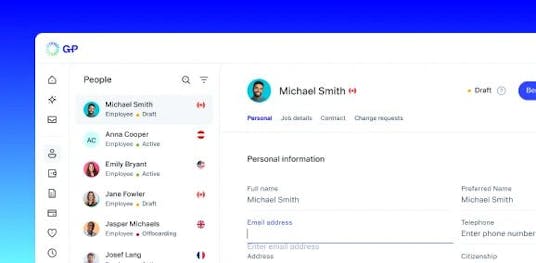

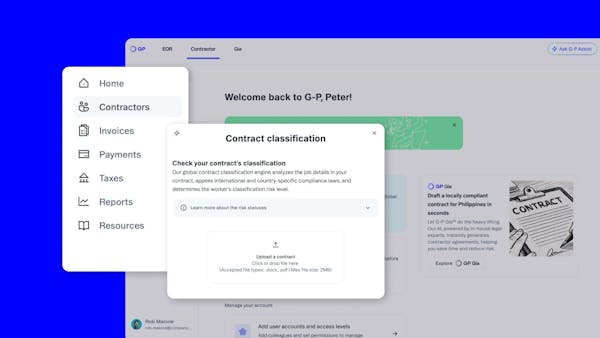

Introducing the new G-P Contractor™ experience

The #1 mistake global companies make when designing employee benefits plans

Minimum wage by country

Guide to salary benchmarking for global hiring

How global EOR derisks strategic plans in a compliance minefield

Technologies powering the future of global EOR

Global EOR’s role in total workforce agility

Mastering global compliance: expert advice from a G-P employment lawyer

Global thinking. Global growth. Let’s go.

countries available

payroll accuracy

global partners

customer satisfaction

countries available

payroll accuracy

global partners

customer satisfaction